AI는 왜 엉뚱한 답을 할까

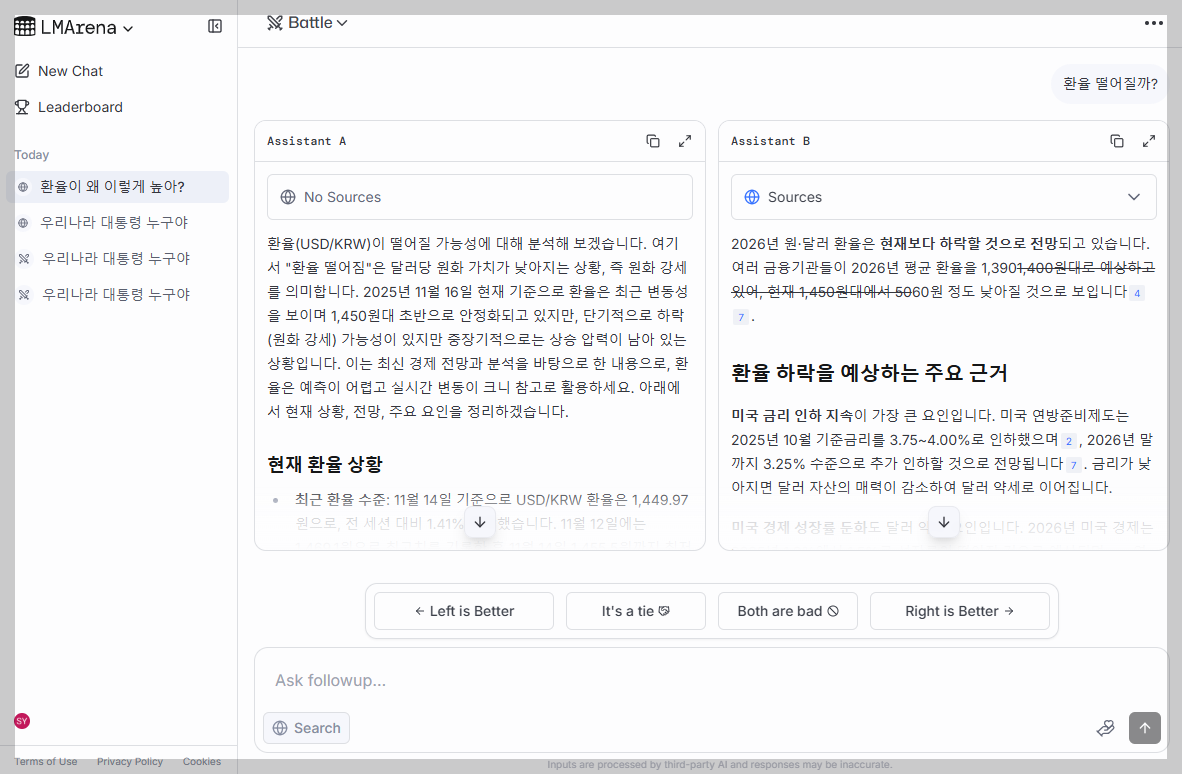

Uesr: 닭가슴살 먹으면 뭐가 좋아?

AI: 닭가슴살은 필수 아미노산이 풍부한 고품질 단백질의 훌륭한 공급원이며 ...

Uesr: 쉬운 요리 추천해줘.

AI: 참치 마요 덮밥 조리법을 알려드릴게요.

Uesr: 그거 말고 닭가슴살로 할 수 있는 요리를 알려줘.

AI를 쓰다보면 종종 엉뚱한 답을 받을 때가 있다. 나는 도쿄의 날씨를 물어봤는데 AI는 도쿄의 역사를 알려주는 식이다. 이런 현상은 AI가 대화의 맥락(Context)을 제대로 파악하지 못했을 때 생긴다. 위에 나온 대화를 보면, AI가 '닭가슴살'이라는 맥락을 놓쳤다는 걸 알 수 있다. 맥락을 고려했다면, 닭가슴살 요리를 추천했을테지만 엉뚱하게도 참치 마요 덮밥을 추천했다. 유저는 답변에 만족하지 못했고 AI에게 다시 요청을 한다.

이처럼 맥락은 답변 품질과 유저 만족도에 큰 영향을 미친다. 이번 글에서는 AI가 대화를 기억하고 처리하는 방식인 '맥락 인식'에 대해 다룬다. 단기 맥락과 장기 맥락으로 나누어서 살펴보겠다.

단기 맥락(= 진행 중인 대화의 맥락)

단기 맥락은 현재 진행 중인 대화의 맥락을 말한다. 자연스러운 대화를 하려면, ①상대방이 방금까지 했던 이야기를 기억하고 있다가 ②적절한 시점에 활용해야 한다.

먼저, 대화 내용을 얼마나 많이 기억하느냐는 컨텍스트 윈도우(Context Window)라는 것과 관련이 있다. 컨텍스트 윈도우는 AI에게 한번에 입력할 수 있는 토큰 수를 뜻하는 말인데, 대화 내용을 적어두는 화이트보드와 같은 역할을 한다. 상상을 해보자. AI랑 대화를 할 때, 모든 대화 기록을 화이트보드에 적는다. AI는 화이트보드를 보면서 답한다. 화이트보드가 꽉 차면, 오래된 대화는 지우고 그 자리에 새로운 대화 내용을 채운다. 그래서 화이트보드(혹은 컨텍스트 윈도우)가 크면, 더 많은 대화 맥락을 AI가 기억할 수 있다. (물론, 컨텍스트 윈도우를 반드시 맥락 데이터로 채워야 하는 것은 아니다.)

| Model | Context window |

| GPT 5 | 400,000 (40만) |

| Gemini 2.5 pro | 1,000,000 (100만) |

| Claude Sonnet 4.5 | 기본 200,000 (20만) 최대 1,000,000 (100만) |

모델별 컨텍스트 윈도우 비교 자료(2025년 11월 기준)

그런데 컨텍스트 윈도우가 크다고 해서 맥락 인식 능력이 반드시 더 좋은 것은 아니다. 화이트보드에 너무 많은 데이터가 있으면 필요한 것을 찾지 못할 수도 있다. 그래서 컨텍스트 윈도우 크기 뿐만 아니라 맥락 데이터를 정확히 뽑아내서 활용하는 능력도 함께 고려해야 한다.

그렇다면 맥락 인식 능력은 어떻게 파악할 수 있을까? 이것은 객관적인 지표로 파악하기 어렵다. 같은 답변을 두고도 누군가는 맥락에 맞다고 평가하고 누군가는 그렇지 않다고 평가하기 때문이다. 따라서, 유저의 만족도를 가지고 모델의 성능을 간접적으로 살펴보는 것이 낫다.

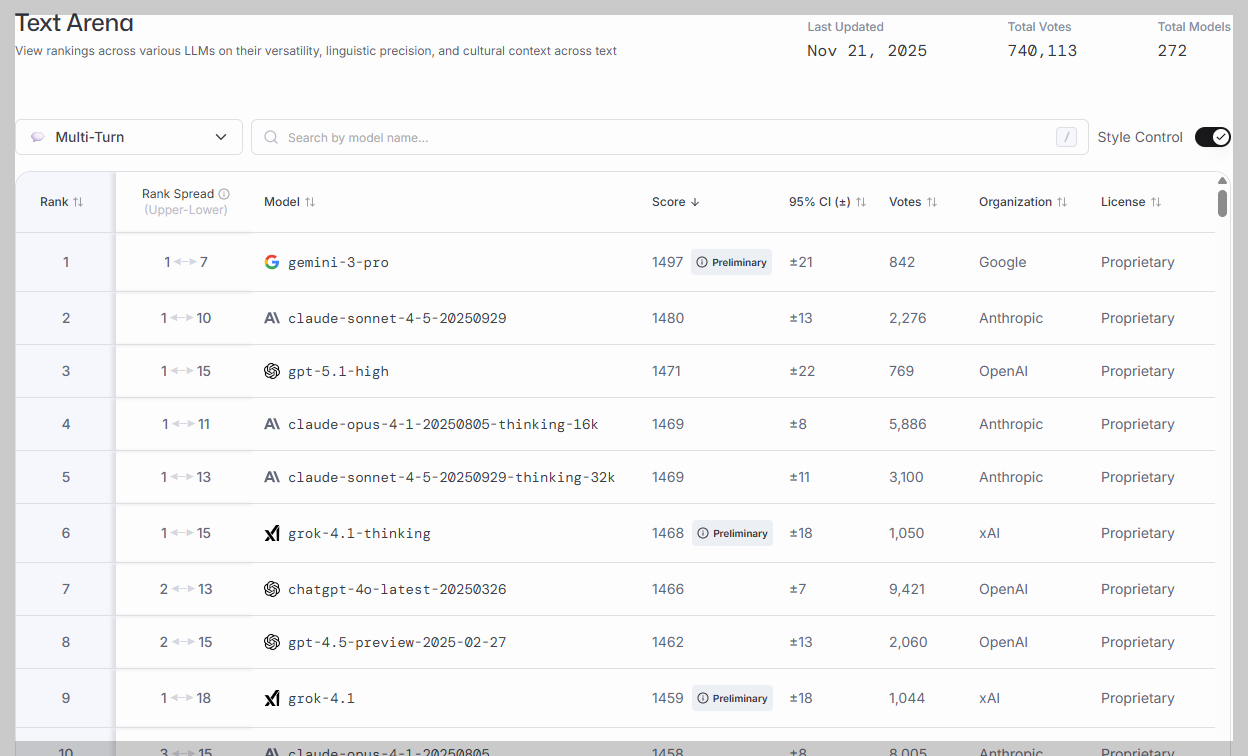

LM Arena에서 살펴본 모델 순위

LM Arena라는 곳에서 이런 자료를 제공하고 있어 소개한다. LM Arena는 유저의 주관적인 평가 기준을 집계해서 AI모델의 순위를 매기는 사이트이다. 유저들은 LM Arena에서 모델을 블라인드 테스트한다. 채팅을 입력하면 랜덤한 두 개의 모델이 답변을 제공한다. 유저는 둘 중에서 어떤 모델이 더 나은 답을 했는지 선택한다. LM Arena는 이런 평가 결과를 종합해서 Elo 방식으로 모델별 순위를 매긴다.

Elo는 승패를 나눌 수 있는 1대1 경기에 사용하는 순위 산정 방식이다. 각 플레이어가 상대 플레이어를 이길 확률을 계산해서 Elo 점수를 산정한다. LM Arena에서 Elo rating이 높다는 것은 블라인드 테스트에서 유저들에게 그만큼 많은 선택을 받았다는 것을 뜻한다.

아래는 LM Arena에서 가져온 LLM 순위 자료다. AI와 여러번 대화를 주고 받는 상황인 'Multi-Turn' 기준 순위이다. 맥락 인식 능력은 여러 번 대화를 주고 받아야 드러나기 때문에 Multi-Turn 기준의 자료를 가지고 왔다. 2025년 11월 21일 기준, Gemini 3 pro가 가장 좋은 평가를 받고 있다.

분량이 많아 이번 게시글에서는 "단기 맥락"만 다룬다. "장기 맥락"은 다음 게시글을 참고해주시 바란다.

2025.11.16.

'AI' 카테고리의 다른 글

| [AI 지식] GPT는 정말로 거짓말을 더 많이 할까? (0) | 2025.12.06 |

|---|---|

| [AI 지식] 왜 못알아듣지? 맥락 인식의 비밀(2/2) (0) | 2025.11.23 |

| [프롬프트 작성 팁] AI 답변 읽다 지친다면? '구조화'로 검토 시간 줄이기 (0) | 2025.11.12 |

| [프롬프트 작성 팁] AI 답변, 원하는 포맷으로 받기(마크다운 활용법) (0) | 2025.11.09 |

| [프롬프트 작성 팁] 출처 밝히기, AI의 거짓말에 속지 않으려면? (0) | 2025.11.02 |