지난 글에서는 AI 맥락 인식 능력 중 단기 맥락을 다뤘다. 오늘은 장기 맥락에 대해 이야기해보겠다.

장기 맥락(=과거 대화에 대한 기억)

오랫 동안 알고 지낸 사람과의 대화는 즐겁다. 마음도 편하고 위로를 받기도 한다. 왜 그럴까? 아마, 상대가 나에 대해서 잘 알고 있기 때문일 것이다. 내가 어떤 경험을 했는지, 내가 뭘 좋아하는지, 내가 어떤 고민을 갖고 있는지 알기에 상대는 내가 듣고 싶은 말을 해줄 수 있다.

이는 AI도 똑같다. AI가 나에 대해서 잘 안다면, AI와의 대화가 훨씬 편하고 즐거울 것이다. 실제로 ChatGPT와 Gemini는 이런 대화 경험을 제공할 수 있는 기반을 갖추고 있다. 두 서비스는 과거 대화 이력을 저장해두었다가 이를 참고해서 답변을 생성한다. 그래서 GPT나 Gemini를 오래 사용한 유저는 AI에게 배경 지식을 일일이 설명할 필요가 없다. 내가 어떤 일을 하는지, 무엇에 관심이 있는지를 AI가 이미 알고 있기 때문이다. 서비스 사용 기간이 길어질수록 AI는 유저의 정보를 더 많이 갖게 되고, 유저에게 딱 맞는 답변을 할 확률은 높아진다. 그러다 보니, 유저들은 "GPT는 대충 말해도 알아듣는데 다른 서비스는 똑같이 물으면 엉뚱한 소리를 하는" 경험을 하게 된다. 이는 서비스에 대한 강한 락인(Lock-in) 효과를 만든다.

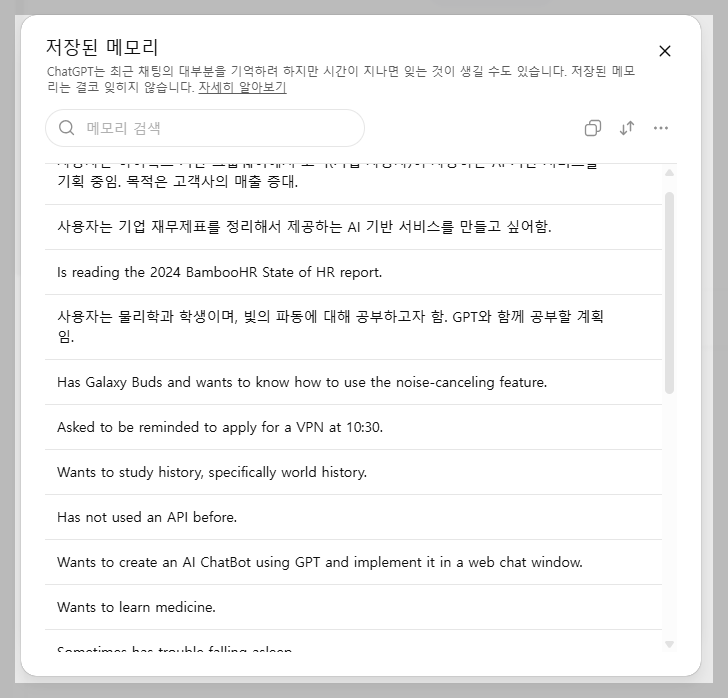

아래는 ChatGPT와 Gemini의 메모리 기능이다. 내가 AI와 나누었던 대화가 정리된 형태로 저장된 것을 볼 수 있다.

API로 만든 서비스의 성능이 떨어지는 이유

GPT API로 서비스를 만들었는데 답변 품질이 ChatGPT만큼 나오지 않는 경우가 있다. 많은 원인이 있겠지만, 맥락 인식이 충분히 되지 않을 때에도 이런 현상이 나타난다. 단순히 LLM API만 가져다 서비스를 만들면, AI는 맥락에 대한 고려없이 대답을 하기 때문이다. 사용자의 질문 뿐만 아니라 과거 대화 이력도 함께 API에 전송해주어야 맥락에 맞는 답을 받을 수 있다.

이를 기술적으로 구현하는 것이 그리 어려운 것은 아니다. 다만, 문제는 비용이다. 처음에는 사용자의 질문 한 줄만 API로 전송하면 되지만, 나중에는 이전 대화 내용도 함께 보내야 해서 데이터 크기가 몇 배로 커진다. API로 전송하는 데이터가 늘어나면 비용도 그만큼 늘어난다.

[맥락 데이터 전송 예시]

User: 오늘 날씨 어때? → 처음에는 이것만 API로 보낸다.

AI: 오늘은 비가 많이 올 것 같으니, 우산을 준비해주세요.

User: 우산 하나 추천해줘.

AI: 직장인이사라면 가방에 넣을 수 있는 접이식 우산을 추천드려요.

User: 우비는 어때? → 이 단계에서는 질문과 이전 대화를 함께 보내야 하기 때문에 데이터양이 5줄로 늘어난다.

비용을 많이 써야 품질이 높아지는 구조라 서비스 제공 업체들은 타협점을 찾을 수 밖에 없다. 단기 맥락은 최대 10줄만 전송한다거나 장기 맥락은 포기한다거나 하는 식으로 말이다. 물론, 맥락의 범위를 줄이더라도 답변 품질이 크게 떨어지지는 않는다. 서비스의 성격에 따라 이것은 거의 느껴지지 않을 수도 있다. 그러나 범용 채팅 서비스를 제공하는 업체라면 이야기가 다르다. ChatGPT, Gemini, Claude 등 글로벌 서비스의 높은 품질에 익숙해진 유저는, 타 서비스의 답변 품질이 떨어진다고 느끼게 된다.

끝.

2025.11.23.

'AI' 카테고리의 다른 글

| [AI 지식] 100명에게 100개의 UI를, 생성형 UI (1) | 2025.12.17 |

|---|---|

| [AI 지식] GPT는 정말로 거짓말을 더 많이 할까? (0) | 2025.12.06 |

| [AI 지식] 왜 못알아듣지? 맥락 인식의 비밀(1/2) (0) | 2025.11.16 |

| [프롬프트 작성 팁] AI 답변 읽다 지친다면? '구조화'로 검토 시간 줄이기 (0) | 2025.11.12 |

| [프롬프트 작성 팁] AI 답변, 원하는 포맷으로 받기(마크다운 활용법) (0) | 2025.11.09 |